La grande majorité des systèmes de positionnement en intérieur utilisent des ondes radio comme vecteur de communication. La transmission s’effectue entre un tag mobile et un réseau d’antennes fixes (aussi nommées "ancres").

Les algorithmes de positionnement sous-jacent se répartissent en différentes catégories selon la nature de l’information utile. Chacun d’eux s’adapte autant à la technologie support qu’à la disposition de l’espace cible.

Ce second article dédié à la géolocalisation indoor par ondes radio se propose donc de présenter ces divers principes. Un comparatif des différentes technologies est par la suite réalisé, permettant ainsi de mettre en avant leurs différentes caractéristiques et cas d'utilisation courants.

Principes de positionnement

Dans la suite l’architecture des systèmes sera composée d’un tag mobile et solidaire de la personne ou l’objet à localiser, ainsi que d’un réseau d’antennes, déployées au sein de l’environnement à des positions connues et préalablement enregistrées dans une base de donnée.

Méthode de mesure des angles d’arrivée (AOA)

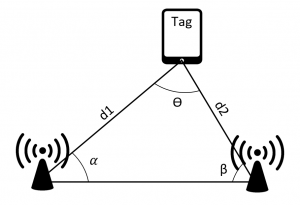

Cette première méthode dite de l’angle d’arrivée (Angle Of Arrival) exploite les angles des signaux émis par le tag mobile à destination d’au moins deux antennes environnantes..

Après détermination des angles de réception, la position du mobile est obtenue par l’intersection des droites passant par chaque référence : on parle de triangulation.

[caption id="attachment_5056" align="aligncenter" width="460"] Figure 1 : Principe de triangulation à partir de deux antennes réceptrices[/caption]

Figure 1 : Principe de triangulation à partir de deux antennes réceptrices[/caption]

Le principal avantage du procédé est qu’il ne nécessite que deux antennes de référence afin d’interpoler une position en espace 2D. Par ailleurs, aucune synchronisation temporelle n’est requise entre les divers équipements.

Toutefois, l’estimation de l'angle de provenance des signaux est un processus complexe et onéreux.

Les systèmes introduisent usuellement de larges réseaux d’antennes directionnelles contribuant à augmenter la taille et la complexité du hardware. Enfin le système souffre particulièrement de l’influence des trajets multiples ainsi que des phénomènes de dispersion du signal (diamètre du faisceau de plus en plus important). L’estimation n’est par ailleurs plus possible lorsque l’émetteur se trouve sur la même ligne que les récepteurs.

Méthode de mesure des temps d’arrivée (TOA)

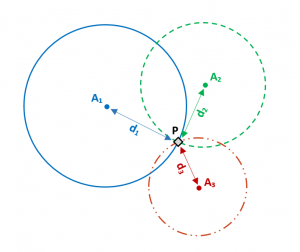

Ce procédé s’appuie sur le temps de propagation d’un signal, entre l’émission par le tag mobile à l’instant Ti puis la réception au niveau d’une antenne à l’instant Tf. Ces différents horodatages justifient l’appellation de la méthode, dite de "Time Of Arrival".

Pour chaque antenne, ce temps de propagation peut ensuite être corrélé à une distance d = c * (Tf – Ti), vis-à-vis du tag. Leur position dans l’environnement étant connue, l’utilisateur se repère alors quelque part sur le cercle de rayon d et d’origine l’antenne en question.

Répéter cette opération pour un minimum de trois antennes permet d’extraire une position en espace 2D (à l’intersection des 3 cercles alors construits). Le procédé est dit de "trilatération".

[caption id="attachment_5053" align="aligncenter" width="460"] Figure 2 : Principe de trilatération utilisé dans la méthode de TOA[/caption]

Figure 2 : Principe de trilatération utilisé dans la méthode de TOA[/caption]

Le principal inconvénient de cette méthode est qu’elle nécessite une synchronisation extrêmement précise entre les différents nœuds. Ainsi dès lors que le tag émet une trame, l’horodatage exact doit être transmis à l’ensemble du réseau d’antennes, sous peine d’écarts importants.

Mesure des différences de temps d’arrivée (TdOA)

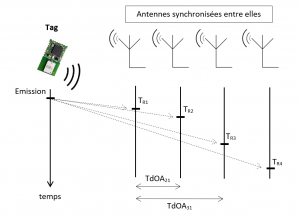

La localisation par TdoA (Time Difference Of Arrival) est une variante s’appuyant sur la différence des temps d’arrivée des signaux entre plusieurs paires de récepteurs.

Le procédé est très similaire aux méthodes de ToA, mais permet de s’affranchir de la synchronisation temporelle entre émetteur et récepteur, toutefois la synchronisation temporelle entre les ancres réceptrices doit demeurer extrêmement précise.

En pratique une ancre maîtresse est donc en charge de communiquer son horloges aux autres récepteurs à proximité. Par la suite le tag émet à intervalles réguliers de courts messages diffusés en broadcast. La différence entre les temps d’arrivée du signal au couple de capteurs traduit une différence de distance entre l’objet à localiser et ce même couple.

Celui-ci se situe alors sur une hyperbole ayant pour foyer les deux récepteurs. Sa position exacte est finalement obtenue après réitération du processus, à l’intersection des hyperboles construites (cf Figure 3)

[caption id="attachment_5048" align="aligncenter" width="550"] Figure 3 : Illustration de la méthode de TDoA[/caption]

Figure 3 : Illustration de la méthode de TDoA[/caption]

Contraintes temporelles et mesure du temps de propagation aller-retour (TWR)

Les méthodes précédemment décrites demandent de fortes contraintes de synchronisation temporelle. En considérant la vitesse de la lumière, un retard d’une dizaine de nanosecondes engendre une incertitude de près de 3 mètres.

En pratique une telle précision est difficilement atteignable. Les principaux protocoles réseau de synchronisation d’horloge (NTP, IRIG-B et PTP) n’offrent respectivement que 50 ms, 1 us et 20 ns de précision. De surcroît le déploiement de telles structures engendre de nouveaux frais tout en complexifiant le système.

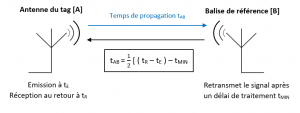

Aussi, de nombreux systèmes à support temporel choisissent de considérer un temps de propagation aller-retour, le principe est dit de "Two Way Ranging TOA".

Méthode de TWR – TOA

Ce procédé reprend les étapes usuelles de la méthode de TOA, la différence d’horodatage entre l’émission et la réception permettant de déterminer le temps de propagation.

Cependant le temps de parcours entre deux nœuds est ici obtenu sur un trajet aller-retour de sorte que l’horloge au niveau de l’antenne réceptrice n’intervient plus dans l’équation.

Celle-ci, après réception de la trame à l’instant t1, la ré-émet à destination du tag à l’instant t2.

Le délai (t2 – t1) = tmin révèle ainsi tous les retards matériels et logiciels survenant lors de la transaction (passage du second module de récepteur à émetteur par exemple).

La détermination expérimentale de tmin (généralement par une série de transactions à faible distance) constitue ainsi la dernière étape d’initialisation avant obtention d’un système fonctionnel (cf Figure 4).

[caption id="attachment_5047" align="aligncenter" width="600"] Figure 4 : Principe de mesure du temps de propagation entre deux nœuds[/caption]

Figure 4 : Principe de mesure du temps de propagation entre deux nœuds[/caption]

Inconvénients de méthode :

Pour calculer l’emplacement d’un tag le processus précédent doit être répété séquentiellement avec toutes les ancres du système, de fait la fréquence de rafraîchissement maximale est assujettie au nombre d’antennes disponibles. Par ailleurs chaque module doit désormais endosser la double fonction d’émetteur / récepteur.

Méthodes reposant sur la puissance des signaux reçus (RSS)

Comme le suggère l’intitulé ces méthodes s’appuient sur la puissance du signal reçu (soit au niveau du nœud cible (tag) soit au niveau des nœuds de référence (ancres fixes), selon le module à l’origine de l’émission. En particulier les algorithmes reposant sur la RSS (Received Signal Strength) se répartissent en deux catégories.

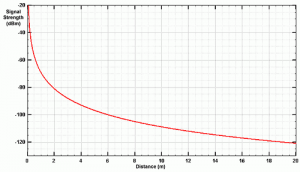

- Les premiers reposent sur une corrélation directe "Puissance = f(distance)". La puissance mesurée, au niveau du tag par exemple, est alors jugée représentative de la distance vis à vis des antennes de référence, leur position étant une nouvelle fois connue. Ainsi, une fois ces distances estimées pour un minimum de 3 antennes, le système utilise le principe de trilatération afin d’extraire la position du mobile. Différentes équations mathématiques permettent de modéliser le comportement du canal, quantifiant ainsi l’atténuation du signal en fonction de la distance parcourue. L’évolution est usuellement logarithmique.

[caption id="attachment_5091" align="aligncenter" width="600"] Figure 5 : Exemple de l’évolution de la force du signal avec la distance (Technologie RFID)[/caption]

Figure 5 : Exemple de l’évolution de la force du signal avec la distance (Technologie RFID)[/caption]

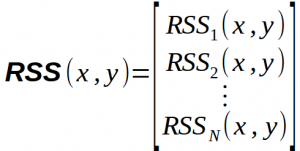

- La seconde catégorie quant à elle, nécessite la construction d’un jeu de donnée lors d’une première phase d’initialisation, elle est dite de "Fingerprinting". En amont de la localisation, une base de données est constituée. Celle-ci contient tous les relevés de puissance pour un ensemble de positions fixes dans la ou les pièces étudiée(s). Aussi, en supposant que les puissances de N balises émettrices soient observables à la position (x, y), les informations suivantes sont enregistrées et constituent une empreinte:

Le processus se répète ensuite à une position différente permettant alors d’établir une véritable cartographie du milieu.

[caption id="attachment_5055" align="aligncenter" width="900"] Figure 6 : Illustration du principe de Fingerprinting[/caption]

Figure 6 : Illustration du principe de Fingerprinting[/caption]

Lors du prochain passage en phase de localisation, l’appareil interroge la base de donnée afin d’associer l’empreinte observée à une position dans l’espace. La précision du positionnement dépend du nombre de positions enregistrées ainsi que du nombre de balises déployées.

Quelques restrictions existent toutefois quant à l’acquisition des mesures. Notamment, compte tenu de l’activité humaine ou encore du phénomène de bruit blanc, des fluctuations de puissance peuvent survenir lors de la phase offline (phase de constitution de la base de donnée). Afin de limiter ces interférences, les puissances enregistrées sont moyennées pour chaque position.

Cette seconde méthode de cartographie a pour mérite de tenir compte des spécificités du milieu. Les puissances observées reflètent les atténuations des murs ou du mobilier. La construction préalable de la base de données permet alors de répertorier les singularités de chaque position.

Ainsi le processus offre usuellement de meilleurs résultats en milieu dense, ce qui justifie son importante utilisation. A l’inverse, une simple corrélation distance/puissance est plus susceptible d’engendrer de lourdes imprécisions.

Comparatif des différentes méthodes :

Les méthodes précédemment décrites admettent des atouts et faiblesses justifiant leur emploi selon le contexte. Ces caractéristiques sont résumées dans le tableau suivant :

[caption id="attachment_5112" align="aligncenter" width="900"] Figure 7 : Synthèse des différents principes de localisation par ondes radio[/caption]

Figure 7 : Synthèse des différents principes de localisation par ondes radio[/caption]

Dans le cas des méthodes de RSS, les incertitudes de mesures sont communément réduites par un post traitement. Le filtrage de Kalman ou le filtrage particulaire sont alors des outils très appréciés [1].

Les ondes radio appliquées à la géolocalisation

Dans la section précédente divers principes de positionnement ont été exposés. Toutefois le choix de la méthode à implémenter reste également lié à la technologie support, c’est à dire la nature de l’onde radio.

Il s’agit alors de tirer parti des avantages de chacune d’entre elles afin de pallier aux divers inconvénients de méthode.

-

Les ondes Wi-Fi

Le Wi-Fi positioning system (norme IEEE 802.11) utilise la détection de réseaux Wi-Fi afin d’accéder à la position de l’usager. Souvent couplé à une autre technologie, il est aujourd’hui très utilisé dans les solutions de localisation indoor pour son implémentation simple et bas coût.

Le principe de positionnement ici à l’œuvre repose sur la force du signal reçu (RSS).

Comme le suggère la méthode, l’utilisateur accède donc aux données de puissance des points d’accès environnants. Il n’est toutefois pas nécessaire de se connecter aux réseaux.

Par la suite, l’emploi de la méthode de Fingerprinting s’avère le plus souvent judicieux.

En effet, les points d’accès Wi-Fi offrent généralement de grandes portées (jusqu’à plusieurs centaines de mètres selon le modèle, sur la fréquence des 2.4 GHz). Ainsi, de nombreuses mesures de puissances contribuent à constituer chaque empreinte, augmentant de fait la fiabilité.

Atouts et faiblesses :

A travers le principe de fingerprinting les systèmes de positionnement Wi-Fi atteignent usuellement des précisions de 2 à 5 mètres en milieu dense, avec une faible consommation énergétique.

Par ailleurs, si le Wi-Fi est encore massivement appliqué à la géolocalisation c’est également en raison des faibles coûts d’implantation.

En pratique il n’est pas rare que les espaces cibles disposent nativement de quelques bornes réseau, autrement dit d’une infrastructure sur laquelle le système peut d’ores et déjà s’appuyer. Une fois leur position relevée, ces points d’accès peuvent être aisément intégrés dans l’algorithme de positionnement, ils contribuent alors à l’obtention de meilleurs résultats.

De nos jours encore, la localisation par Wi-Fi est au centre de nombreuses recherches et la précision offerte ne cesse d’augmenter. (exemple du système "Chronos" développé par le MIT. Principe permettant d’atteindre une précision décimétrique à l’aide d’un unique point d’accès [2])

Compléments sur les aspects de sécurité : être lucide quant à la portée des données

Si la précédente méthode peut être exploitée en créant soi-même son réseau personnel, on oublie parfois que la portée des signaux outrepasse aisément la frontière des habitations.

Aussi, au niveau mondial, de nombreuses entreprises s’affairent à constituer des bases cartographiques recensant ces points d’accès. L’entreprise Google, pour ne citer qu’elle, avait pour habitude d’utiliser ses Street View Cars afin d’établir une liste de tous les points d’accès Wi-Fi rencontrés. Ces données étaient ensuite associées à la géolocalisation GPS de la voiture afin d’accroître la précision.

Seulement, la maintenance de la base de données par ce principe s’avère épineuse. Depuis quelques années maintenant, l’utilisateur est directement mis à contribution.

En effet, pour collecter de nouvelles données de localisation, de grands groupes n’hésitent pas à s’appuyer directement sur les smartphones et tablettes des usagers. Les appareils disposant d’une connexion transmettent alors périodiquement leurs identifiants, leurs positions GPS ainsi que l’empreinte Wi-Fi des réseaux avoisinants.

Le procédé peut paraître anodin, pourtant de telles initiatives peuvent rapidement devenir problématiques.

En pratique, rien n’empêche chaque point d’accès Wi-Fi d’enregistrer ces "Probe Requests" en provenance du téléphone. Même sans connexion effective, l’utilisation de sniffers Wi-Fi permet alors de consigner la présence, les heures de passage ou encore les habitudes de l’usager.

Partant de ce constat, de nombreux systèmes de surveillance / tracking virent le jour. Pour reprendre l’expression de Tuxicoman sur le blog du même nom : "C’est en quelque sorte le cookie web en version IRL."

Remarque sur les agissements de Google et ses homologues : Quid de la vie privée des personnes et de leur anonymat ? Pour la CNIL les possesseurs de points d’accès Wi-Fi doivent être en mesure de s’opposer à la collecte d’informations relatives à leur point d’accès, celles-ci devant par ailleurs demeurer anonymes. De surcroît elle estime que la la société se doit de communiquer largement sur ce sujet. (http://www.netpublic.fr/2012/01/geolocalisation-et-points-d-acces-wifi/)

Ces critiques font suite à la réponse de Google, qui était loin de faire l'unanimité : https://www.numerama.com/magazine/20587-google-permet-d-interdire-le-scan-de-son-reseau-wifi.html

Pour saisir l'ampleur du phénomène (Big Brother keeps watching you) :

L’article de Tuxicoman : https://tuxicoman.jesuislibre.net/2015/10/tracking-par-les-emissions-wifi-et-bluetooth.html

Comment réduire sa vulnérabilité : https://medium.com/@brannondorsey/wi-fi-is-broken-3f6054210fa5

-

Le Bluetooth Low Energy (BLE)

L’intérêt du Bluetooth pour des applications de géolocalisation est apparu en 2010 avec la naissance du « Bluetooth Low Energy » (BLE, version 4.0) aussi couramment appelé « Bluetooth Smart ».

Cette nouvelle norme, spécialement développée pour des applications autour de l’internet des objets, propose notamment une consommation de puissance extrêmement réduite. Elle permet de fait la mise en place de systèmes pérennes et autonomes.

En particulier les systèmes de localisation bluetooth s’appuient sur des balises sans fil nommées « beacons » dont la portée d’émission avoisine généralement quelques dizaines de mètres.

Placés en intérieur au niveau des lieux stratégiques, ils sont majoritairement déployés par les enseignes de distribution à des fins de geofencing : lorsqu’un utilisateur pénètre dans le périmètre, une information contextualisée peut lui être transmise.

[caption id="attachment_5096" align="aligncenter" width="450"]![]() Figure 8 : Quelques exemples de Beacons disponibles à la vente[/caption]

Figure 8 : Quelques exemples de Beacons disponibles à la vente[/caption]

Néanmoins cette détection par zone peut également être utilisée à des fins de géolocalisation. Dans ce contexte, et en raison des faibles fluctuations des signaux Bluetooth, c’est une nouvelle fois la puissance mesurée qui constitue le vecteur de l’information.

Sur le terrain, le terminal mobile est donc en charge d’enregistrer les puissances de signaux en provenance des beacons. Par la suite l’algorithme de trilatération RSS avec corrélation puissance/distance est à privilégier.

En effet, les beacons admettent un périmètre d’émission restreint (signal supposé exploitable en dessous des 15 m), de fait le recouvrement de zone nécessaire au Fingerprinting est limité. En revanche les mesures de RSSI (Received Signal Strength Indication) dans les espaces desservis sont, de fait, plus significatives.

Cependant cette méthode admet ses limites en environnements denses dans lesquels la prise en compte des caractéristiques du milieu s’avère primordiale.

Atouts et faiblesses :

Dans les grands axes, la technologie bluetooth appliquée à la géolocalisation admet des caractéristiques similaires à celles de son voisin le Wi-Fi. Le standard offre une précision souvent supérieure (de l’ordre de 1 à 3 mètres) mais nécessite toutefois une couverture plus dense, en raison de la moindre portée.

En somme les beacons se démarquent principalement de par leur autonomie (plusieurs années d’utilisation sur batterie, selon l’usage). Cette durée de vie importante, ainsi que la présence native de la norme BLE sur de nombreux appareils embarqués, en font des candidats attractifs pour les applications de localisation.

-

L’utilisation du RFID

La technologie RFID est couramment utilisée afin d’identifier des objets dans un faible périmètre. Elle repose sur l’utilisation conjointe de lecteurs et d’un tag RFID, ce dernier pouvant être passif ou actif.

Dans la configuration passive le tag opère sans aucune source d’alimentation propre.

Il utilise alors un transfert d’énergie électromagnétique en provenance du lecteur, afin d’émettre à son tour à très courte distance.

Par conséquent le procédé ne permet qu’une micro-localisation. L’utilisateur doit impérativement se trouver au contact d’un lecteur et interagir avec celui-ci (principe des badges automatiques avec une portée de quelques centimètre, au mieux).

A l’inverse les tags actifs disposent de l’initiative de communication. Bien que plus coûteux, les systèmes admettent une portée accrue, usuellement de l’ordre d’une dizaine de mètres. Similairement au Bluetooth, la position de l’utilisateur est extraite des puissances mesurées au niveau des lecteurs. Un certain nombre d’entre eux doit ainsi être à proximité.

Atouts et faiblesses :

A supposer que la couverture en lecteurs soit convenable, la technologie RFID offre communément une précision métrique tout en admettant une faible consommation énergétique.

Toutefois, en raison d’une portée encore trop faible, engendrant des coûts d’infrastructure plus important, la technologie reste peu attractive dans un contexte de géolocalisation. Pour des contextes similaires on lui préférera ainsi son homologue le BLE.

-

L’Ultra Wide Band (UWB)

Au delà d’une technologie, l’UWB (norme IEEE 802.15.4a) est avant tout une technique de modulation radio originairement utilisée pour les communications sans fil. Elle repose sur la transmission d'impulsions de très courte durée, souvent inférieure à la nanoseconde.

Le standard définit deux critères que doit respecter un signal afin d’être qualifié d’ultra large bande :

– Avoir une largeur de bande absolue au moins égale à 500 MHz (la bande étant définie comme la différence entre les deux points à -10 dB du maximum de spectre).

– Avoir un rapport largeur de bande sur fréquence centrale au moins supérieur à 20%.

Soit pour cette dernière condition, (FH - FL) / FC = 2*(FH - FL) / (FL + FH) ≥ 20%

Avec, FH : fréquence haute à -10dB

FL : fréquence basse à -10dB

FC : fréquence centrale

En parallèle de ces singularités les signaux UWB respectent aussi des réglementations de puissance précisées par le Comité des Communications Électroniques (ECC). Les signaux admettent de fait une très faible densité spectrale de puissance, volontairement en dessous des émissions non intentionnelles de bruit.

Ainsi la cohabitation avec d’autres ondes dans les mêmes bandes de fréquence n’est pas sujet à préoccupation. Les systèmes obtiennent l’initiative dans le choix d'une fréquence porteuse et évitent d’autre part le mécanisme d’allocation de licences (processus obligatoire lors d'utilisation de bandes dites "non libres" [3])

Intérêts quant à la géolocalisation :

Dans les faits, les signaux UWB sont intrinsèquement adaptés à des applications telles que la géolocalisation indoor de par leur très grande largeur de bande.

Dans ce contexte cette spécificité ne se traduit plus en terme de débit mais en terme de résolution temporelle. Aussi, bien que les techniques de positionnement par AOA et RSS restent exploitables, elles ne permettent pas de tirer parti des qualités du signal.

En résulte que seules les méthodes de TOA ou de TDOA exploitent pleinement l’UWB, permettant ainsi d’atteindre une précision centimétrique.

Plus particulièrement l’utilisation de la TOA – TWR représente un bon compromis permettant de s’affranchir des contraintes de synchronisation. Après conception de l’architecture, les signaux UWB offrent alors :

- Une excellente précision (de l’ordre de quelques décimètres, voire centimètres avec une couverture adéquate)

- Une bonne fiabilité, grâce aux nombreuses composantes fréquentielles présentes (leur grand nombre augmentant les chances qu’une partie d’entre elles traverse ou évite un obstacle)

- Une sensibilité moindre aux interférences d’autres systèmes, de par la faible densité spectrale de puissance des signaux

Ces caractéristiques sont très appréciés dans un environnement indoor souvent dense et déjà parcouru par de nombreuses ondes. On notera néanmoins une faible portée d’émission, le signal restant communément exploitable sous 15 m, avant dégradation des performances. Par ailleurs le coût d’implémentation apparaît légèrement plus élevé que pour les technologies Bluetooth ou Wi-Fi (à ce jour, comptez 25€ pour un unique chip UWB optimisé pour la localisation (exemple du développeur "Decawave"))

-

Les ultrasons :

Malgré leur rareté, les systèmes de géolocalisation par ultrasons proposent une approche simplifiée des méthodes de TOA. La vitesse du son étant bien moindre devant celle des précédentes ondes électromagnétiques, la précision de synchronisation est de même moins répressive. Ici un écart de synchronisation d’une milliseconde n’induit "plus" que 34 cm d’incertitude de position.

Ainsi, si compté que tag et balises puissent communiquer sans présence d’obstacles (configuration dite en "Line Of Sight"), une géolocalisation est envisageable et fournit fréquemment des précisions centimétriques.

L’implémentation de tels systèmes reste toutefois restreinte à des espaces peu volumineux, la portée de l’onde n’excédant guère quelques mètres.

SYNTHÈSE :

Les forces et faiblesses des technologies précédentes peuvent être synthétisées à travers le tableau suivant. Les indications de précision et de portée sont ici données à titre comparatif. Ces paramètres étant fortement dépendants des caractéristiques du milieu (densité de l’environnement, nature des matériaux, configuration de l’espace, …)

[caption id="attachment_5050" align="aligncenter" width="1000"] Figure 9 : Caractéristiques des principales technologies de localisation indoor[/caption]

Figure 9 : Caractéristiques des principales technologies de localisation indoor[/caption]

*LOS (Line Of Sight) : La communication s’effectue en ligne de vue directe.

** Détection de cellule : L’information traitée est binaire : le tag est, ou n’est pas, à proximité.

Aussi l’utilisateur est localisé dans une cellule, dont la taille est liée à la portée d’émission. Il est toutefois impossible de positionner le tag au sein de cette cellule sans faire appel à d’autres méthodes, type RSS.

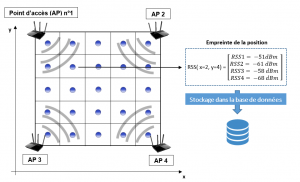

Ces technologies peuvent enfin être mises en parallèle d’un point de vue précision / coût :

[caption id="attachment_5054" align="aligncenter" width="1000"] Figure 10 : Comparaison des différentes technologies en terme de coût et précision (les systèmes du premier article ont également été ajoutés)[/caption]

Figure 10 : Comparaison des différentes technologies en terme de coût et précision (les systèmes du premier article ont également été ajoutés)[/caption]

Dans les faits les systèmes déployés reposent couramment sur des architectures hybrides employant plusieurs technologies. Ainsi dans le cas d’environnements à grandes surfaces il n’est pas rare que beacons et points d’accès Wi-Fi coexistent, selon un principe de fusion des données.

Enfin, comme ce dernier graphe le confirme, les signaux UWB exposent également des caractéristiques avantageuses en terme de localisation.

CONCLUSION :

Comme l’ont souligné ces deux derniers articles, la localisation indoor introduit de nouveaux enjeux, autant en terme de précision que d’infrastructures. Si de nombreuses solutions permettent d’ores et déjà un positionnement en milieu contraint, il y a fort à parier que nouveaux standards viendront bientôt appuyer cette démarche (émergence des technologies Li-Fi, avènement de la 5G, …)

Ainsi, à l’image de l’IPSN [4] ou encore de l’IPIN, compétitions de localisation qui, chaque année rencontrent un franc succès, les systèmes de positionnement en milieu fermé sont enclins à se démocratiser pour, peu à peu, s’intégrer dans notre quotidien.

SOURCES :

[1] Filtre de Kalman et filtre particulaire :

https://fr.wikipedia.org/wiki/Filtre_de_Kalman

https://fr.wikipedia.org/wiki/Filtre_particulaire

[2] Présentation de "Chronos" développé par le MIT :

https://www.youtube.com/watch?v=cJx7ewEyuzo (lien de la thèse en description de vidéo)

[3] Précisions de l'ARCEP quant à l'utilisation des bandes non libres : https://www.arcep.fr/index.php?id=13828

[4] Lien des résultats 2018 de la compétition IPSN : https://www.microsoft.com/en-us/research/event/microsoft-indoor-localization-competition-ipsn-2018/

«Comparing the Performance of Indoor Localization Systems through the EvAAL Framework» - ISTI Institute of CNR

«Techniques et technologies de localisation avancées pour

terminaux mobiles dans les environnements indoor» - Frédéric Evennou

«Evaluation and testing of techniques for indoor positioning» - Hampus Engström & Fredrik Helander

«Ultra Wideband Indoor Positioning Technologies: Analysis and Recent Advances» - Abdulrahman Alarifi,* AbdulMalik Al-Salman, Mansour Alsaleh,Ahmad Alnafessah, Suheer Al-Hadhrami, Mai A. Al-Ammar, and Hend S. Al-Khalifa

«Conception d’un système d’antennes pour la localisation en temps réel avec réseau de capteurs sans fils» - Evanaska Maria Barbosa Nogueira

«Pathapati Subbu, K., Gozick, B., and Dantu, R. 2013. LocateMe: Magnetic-fields-based indoor localization using smartphones.»